Architectures data autonomes : un futur en pilote automatique ?

Demain, les architectures data seront auto-adaptatives, résilientes et intelligentes. Grâce à l’intelligence artificielle, elles surveilleront, optimiseront et corrigeront les pipelines en continu — sans intervention humaine. Une perspective qui promet aux DSI une donnée maîtrisée, performante, et alignée en temps réel avec les exigences métiers.

Mais c’est encore de la science fiction pour de nombreuses entreprises, freinées par des architectures data fragmentées ou vieillissantes, des silos et une automatisation qui reste faible. Pourtant, la transformation est en marche ! En combinant automatisation avancée, intelligence artificielle et modèles d’architecture flexibles, une nouvelle génération de plateformes Data commence à redéfinir les standards. Demain, ces architectures autonomes permettront une gestion quasi auto-pilotée des environnements data : plus réactive, plus agile, et surtout, plus intelligente.

L’émergence des agents autonomes et des pipelines pilotés par l’IA

Jusqu’alors principalement utilisés dans des cas d’usage front-office, les agents autonomes commencent à s’intégrer directement dans les architectures data elles-mêmes. Leur rôle ne se limite plus à dialoguer avec les utilisateurs : ils deviennent des composants actifs de l’environnement data, capables d’intervenir dans le fonctionnement même des pipelines.

Concrètement, ces agents assurent une surveillance en continu des pipilines de données, détectent les anomalies, corrigent automatiquement les erreurs et peuvent même exécuter des tâches complexes. Cela inclut par exemple la régénération automatisée de modèles, le redémarrage intelligent d’un pipeline défaillant, ou encore des actions de dépannage autonomes.

Des solutions comme LangChain couplé à des bases vectorielles, Auto-GPT, ou encore les agents intégrés à Databricks IQ et Snowflake Cortex, ont déjà cette capacité d’orchestration intelligente et proactive. Grâce à ces agents, les plateformes data se transforment progressivement en écosystèmes intelligents, capables de détecter, comprendre et réagir aux événements, sans attendre une intervention humaine.

L’intégration croissante de MLOps, DataOps et FinOps : vers la convergence opérationnelle

L’intégration croissante des MLOps, DataOps et FinOps marque une étape importante dans la convergence des pratiques opérationnelles au sein des architectures modernes. Ces trois disciplines convergent pour créer des plateformes résilientes et optimisées, capables de répondre aux besoins complexes des entreprises.

Le MLOps, ou Machine Learning Operations, se concentre sur l’automatisation du cycle de vie des modèles d’apprentissage automatique. Cela inclut le déploiement, la surveillance continue des performances et la reformation automatique des modèles en cas de dérive des données ou des métriques. Ces pratiques permettent de maintenir les modèles à jour et adaptés à l’évolution des besoins métiers, tout en réduisant les interventions manuelles.

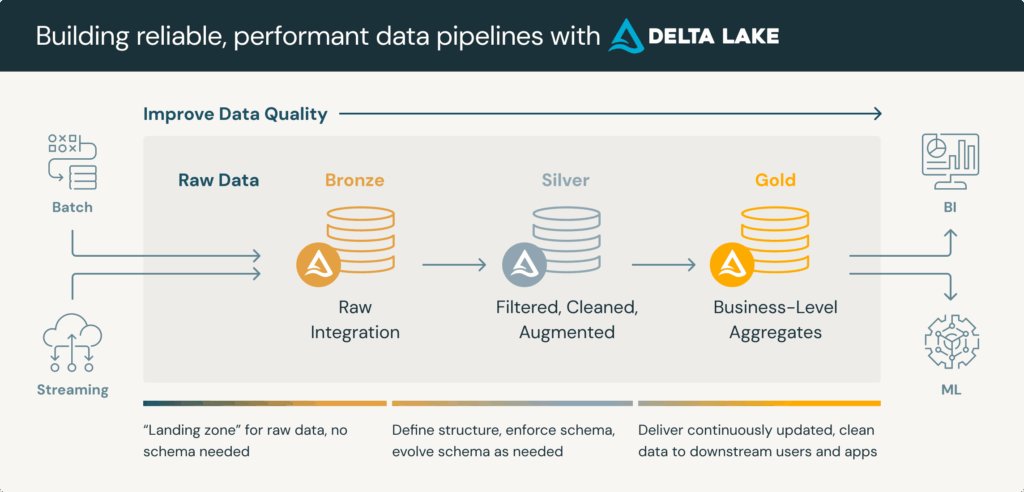

Le DataOps, quant à lui, vise à orchestrer les flux de données avec une attention particulière à la qualité et à la gouvernance. Inspiré du DevOps, il applique des méthodologies agiles pour garantir une intégration fluide et rapide entre les équipes data et IT. Cela permet d’assurer une gestion continue et proactive des pipelines de données, tout en minimisant les erreurs et en améliorant l’efficacité globale.

Le FinOps se concentre sur l’optimisation financière des infrastructures cloud. Il permet de surveiller et d’ajuster en temps réel les coûts liés au stockage, au calcul et au traitement des données en fonction de leur utilisation réelle. Cette approche favorise un dialogue entre les équipes techniques et financières pour garantir que les ressources sont utilisées de manière rentable et alignées sur les objectifs stratégiques.

La convergence des trois fait émerger des plateformes dites self-healing et self-optimizing. Ces systèmes intelligents sont capables de détecter automatiquement les anomalies, d’ajuster leurs paramètres pour corriger les problèmes identifiés et d’alerter les équipes uniquement en cas de dérives significatives. Par exemple, un pipeline DataOps peut redémarrer automatiquement après une défaillance, tandis qu’un modèle MLOps peut être re-entraîné sans intervention humaine grâce à un mécanisme d’auto-réparation.

Cette convergence opérationnelle offre aux entreprises une meilleure résilience, une optimisation continue des coûts et une capacité accrue à s’adapter aux évolutions rapides du marché. Toutefois, elle nécessite une gouvernance solide pour garantir la transparence, la sécurité et l’efficacité dans un environnement technologique toujours plus complexe.

IA générative : le copilote des architectes data

L’IA générative ne se résume déjà plus au simple assistant conversationnel. Désormais intégrée au cœur des processus de gestion et d’analyse des données, elle transforme la manière dont les équipes conçoivent, interrogent et optimisent leurs environnements data.

L’un de ses bénéfices les plus populaires réside dans la génération automatique de code, notamment SQL ou Spark. Grâce à des solutions comme Databricks Assistant ou Microsoft Fabric Copilot, les utilisateurs peuvent créer rapidement des requêtes complexes ou des scripts optimisés, tout en bénéficiant d’explications contextuelles et de corrections automatiques. Cela réduit considérablement le temps de développement et facilite la montée en compétence des équipes techniques.

l’IA générative excelle aussi dans la détection automatisée d’anomalies. Elle identifie les incohérences dans les schémas ou les métriques, et peut proposer des actions correctives en temps réel. Par exemple, elle détecte un ralentissement dans un pipeline et recommande des ajustements pour en améliorer les performances ou réduire les coûts d’exécution. Ces capacités renforcent la résilience des systèmes et permettent une approche proactive face aux incidents.

Autre innovation majeure : la capacité à interagir en langage naturel avec les plateformes data. Cette interface simplifie l’accès à l’information pour les utilisateurs non techniques et démocratise l’usage des outils analytiques dans l’ensemble de l’organisation. On passe ainsi d’une exploitation par des experts de la data à une consommation élargie de la donnée, plus fluide et accessible au plus grand nombre.

Des solutions comme Snowflake Cortex, Databricks IQ ou Microsoft Fabric Copilot incarnent déjà cette nouvelle génération de plateformes intelligentes. Elles intègrent des fonctionnalités d’IA générative non seulement pour répondre aux besoins opérationnels, mais aussi pour anticiper, diagnostiquer et résoudre les problèmes avant qu’ils ne deviennent critiques.

Vers une architecture data auto-pilotée

L’avenir des architectures data ne réside pas dans le seul choix d’outil, mais dans la capacité à construire un système intelligent, interopérable et évolutif. Les plateformes de demain devront s’auto-configurer, s’auto-optimiser et s’adapter en temps réel aux besoins métiers, tout en maintenant une supervision humaine.

Trois fondamentaux technologiques soutiennent cette transformation :

- l’automatisation avancée des pipelines et déploiements,

- l’intégration native de l’IA pour la surveillance et l’optimisation continue,

- une modularité architecturale permettant une évolutivité sans rupture.

Mais cette autonomie croissante soulève aussi de nouveaux défis : gouvernance des systèmes auto-évolutifs, dérives potentielles des modèles en environnement dynamique, ou encore exigence de transparence pour les prises de décision critiques.

À court terme, les architectures hybrides — humain + machine — resteront la norme. Le véritable enjeu est aujourd’hui de concevoir des architectures capables d’apprendre, de s’ajuster et d’évoluer avec agilité, tout en gardant l’humain au centre de la gouvernance.

Chez Smartpoint, ESN pure player Data, nous accompagnons les DSI et les CDO dans cette évolution vers des architectures data intelligentes et durables. Grâce à notre expertise en ingénierie data, cloud, IA et gouvernance, nous aidons nos clients à concevoir des écosystèmes interopérables, automatisés et alignés sur leurs enjeux métiers. Qu’il s’agisse de moderniser une plateforme existante, de cadrer une trajectoire d’architecture ou d’industrialiser des usages IA, nos équipes interviennent de bout en bout, avec une approche pragmatique, modulaire et souveraine. Contactez nos experts.

Vous vous interrogez sur quelle démarche adopter ? Quelle architecture ou quels outils choisir ? Vous avez besoin de compétences spécifiques sur vos projets ? Challengez-nous !

Les champs obligatoires sont indiqués avec *.